为了应对对话总结中的挑战,如对话冗长、角色互动和概念转变,我们引入了Qwen1.5-MoE-A2.7B模型。这款基于MoE(Mixture-Of-Experts)的改进模型通过在不显著增加计算预算的情况下使用大量参数,显著提升了对话总结的效果。

Qwen1.5-MoE-A2.7B模型结合了QLora和FlashAttention技术,以优化训练过程。QLora通过量化低秩适配器来减少内存使用,而FlashAttention-2则提升了训练速度和效率。此外,使用噪声嵌入指令微调(NEFTune)增强了模型的鲁棒性。这些技术使Qwen1.5-MoE-A2.7B在SAMSUM和CSDS对话总结数据集上取得了领先的性能。

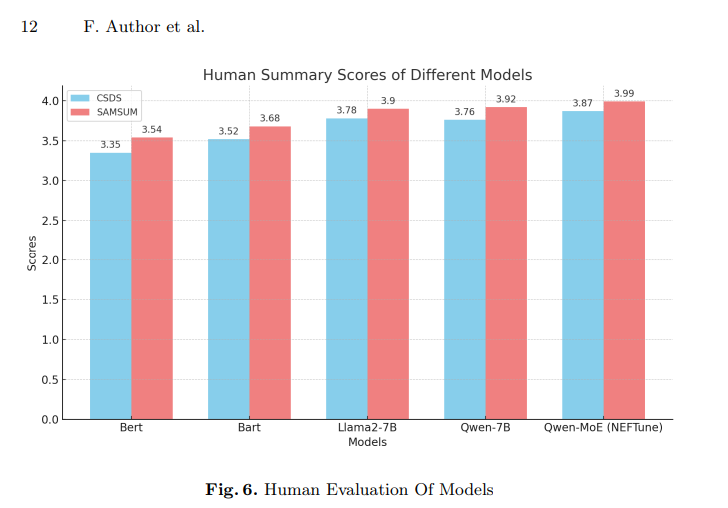

在对话总结领域,传统的小型语言模型如BERT和BART虽然表现良好,但大规模模型通常能带来显著的性能提升。最新的基于LLM的模型如DIALOGLM和GatorTronGPT-20B虽然在对话理解上表现出色,但Qwen1.5-MoE-A2.7B通过细粒度专家和共享专家等创新,达到了与当前最先进模型相当的效果。

通过这些先进的技术,Qwen1.5-MoE-A2.7B显著提升了对话总结的质量和效率,为公司在自然语言处理领域提供了强有力的工具。